Cartographier la perception des phonèmes du français

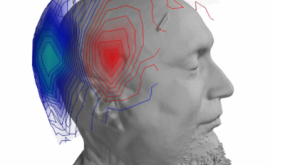

Qu'écoutons-nous vraiment lorsque nous écoutons quelqu'un parler ? Pour répondre à cette question, une équipe de recherche CNRS du Laboratoire des Systèmes Perceptifs et du Laboratoire de Sciences Cognitives et Psycholinguistique a mis en œuvre une méthode expérimentale, appelée image de classification auditive. En analysant les erreurs commises par des individus confrontés à des sons de parole dans un bruit de fond, cette technique a permis de mettre en évidence les éléments acoustiques que les locuteurs et locutrices du français utilisent pour différencier les sons de leur langue. Résultat inattendu : tout le monde ne s'appuie pas sur les mêmes éléments du son de parole pour le comprendre. Cette étude a donné lieu à une publication dans la revue Scientific Reports.

Sans que nous en ayons conscience, notre cerveau accomplit un exploit chaque fois que nous écoutons quelqu'un parler : traduire le son perçu en une série d'unités linguistiques, les phonèmes, tout en faisant abstraction du bruit environnant. Mais sur quelles caractéristiques des sons de parole s’appuie-t-il pour réaliser cette tâche ? Par exemple : quels sont les indices acoustiques qui nous permettent de distinguer les mots bas, tas, pas, gars ou cas, ne différant que par leur phonème initial ? Si cette question semble simple en apparence, il n'existe pourtant à ce jour pas de réponse définitive. Objet de nombreux travaux depuis les années 1920, ce problème a donné naissance à un domaine de recherche à part entière, la phonétique auditive. Ce champ a abouti à des conclusions importantes sur le traitement de la parole par le cerveau humain, néanmoins la question des indices acoustiques sur lesquels l'auditeur ou l'auditrice porte son attention reste toujours en débat.

Lire la suite de l'article sur le site de l'Institut de Sciences Humaines et Sociales du CNRS