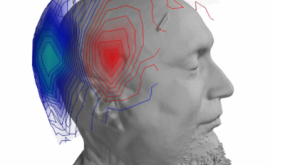

Mapping the perception of French phonemes

What do we really listen to when we hear someone speak? To answer this question, a CNRS research team from the Laboratoire des Systèmes Perceptifs and the Laboratoire de Sciences Cognitives et Psycholinguistique has implemented an experimental method known as auditory classification imaging. By analysing the errors made by individuals confronted with speech sounds in background noise, this technique has made it possible to highlight the acoustic elements that speakers of French use to differentiate the sounds of their language. The unexpected result: not everyone relies on the same elements of speech sound to understand it. This study has been published in the journal Scientific Reports.

Sans que nous en ayons conscience, notre cerveau accomplit un exploit chaque fois que nous écoutons quelqu'un parler : traduire le son perçu en une série d'unités linguistiques, les phonèmes, tout en faisant abstraction du bruit environnant. Mais sur quelles caractéristiques des sons de parole s’appuie-t-il pour réaliser cette tâche ? Par exemple : quels sont les indices acoustiques qui nous permettent de distinguer les mots bas, tas, pas, gars ou cas, ne différant que par leur phonème initial ? Si cette question semble simple en apparence, il n'existe pourtant à ce jour pas de réponse définitive. Objet de nombreux travaux depuis les années 1920, ce problème a donné naissance à un domaine de recherche à part entière, la phonétique auditive. Ce champ a abouti à des conclusions importantes sur le traitement de la parole par le cerveau humain, néanmoins la question des indices acoustiques sur lesquels l'auditeur ou l'auditrice porte son attention reste toujours en débat.

Lire la suite de l'article sur le site de l'Institut de Sciences Humaines et Sociales du CNRS